Ich bin derweil der Frage was eine KI kann bzw. nicht kann etwas näher gekommen. Die besten KIs setzen auf "deep learning". Das hat was mit neuronalen Netzwerken (NN) zu tun, die sehen in etwa so aus:

Zuerst einmal: Ein biologisches Neuron ist sehr viel komplexer als ein solcher Knotenpunkt.

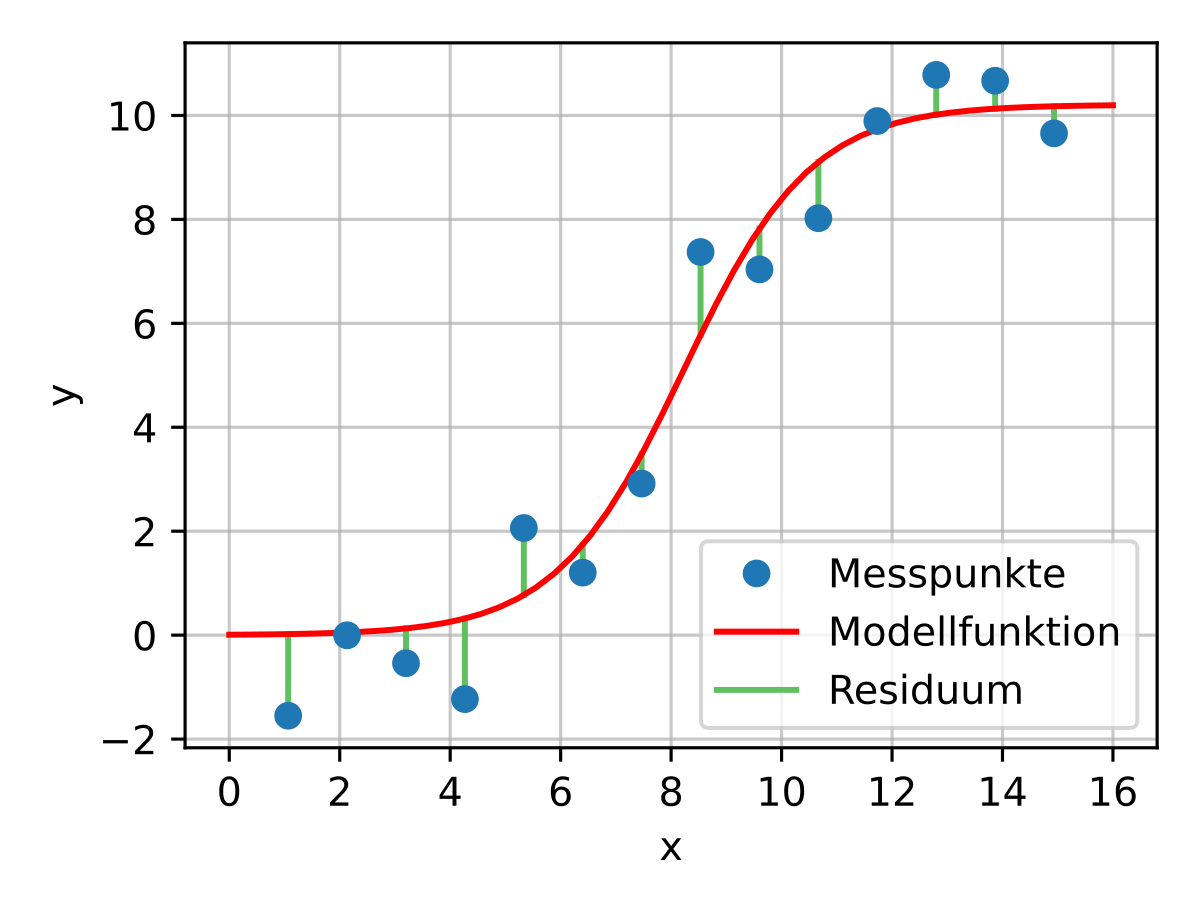

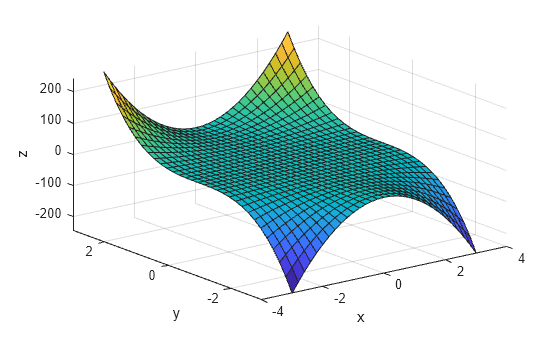

Jeder Knotenpunkt steht für eine mathematische Funktion der Form (wx+b)A(x), also links eine lineare Funktion (eine Gerade) und rechts einer sogenannten "Aktivierungsfunktion", die dafür sorgt, dass die Knotenpunkte des neuronalen Netzwerks zueinander inkommensurabel sind. Die Aktivierungsfunktion ist also irgendetwas nicht-lineares, zb der tangens hyperbolicus.

Ein solches Netzwerk hat noch keinerlei "Intelligenz", man muss das neuronale Netzwerk erst trainieren.

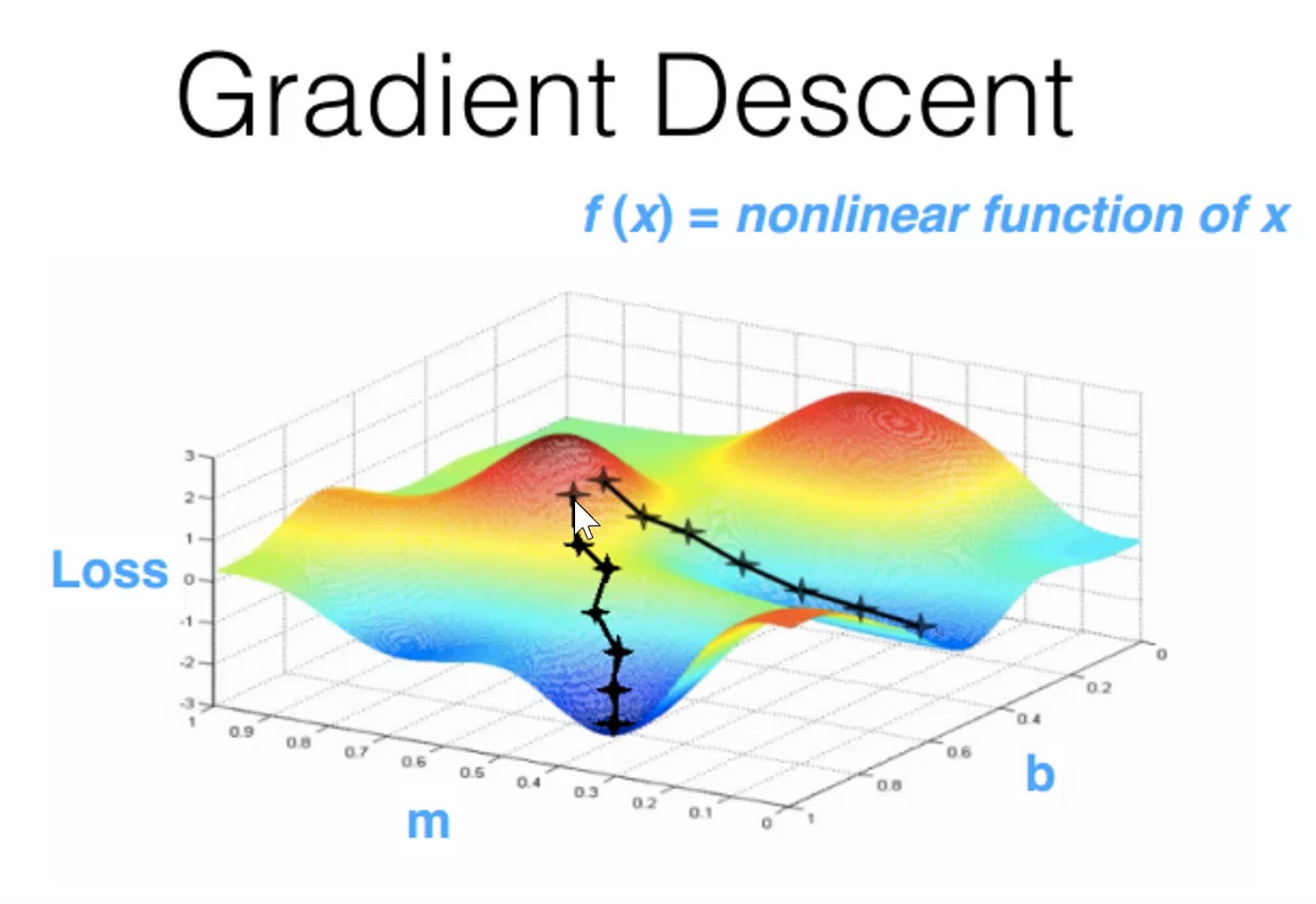

Angenommen wir wollen nun das NN darauf trainieren, Spammails zu filtern, dann hauen wir links eine (möglichst große) Menge Spammails rein, die bestimmte Merkmale aufweisen (zb Wörter, absenderadresse, betreff, Headerinformationen usw. usf, genauere Infos braucht man nicht, man kommt also ohne jede Semantik aus) und sagen dem Netzwerk gleichzeitig, ob es sich um eine spammail oder nicht handelt. Dementsprechend ändert das NN dann die Gewichtungen der einzelnen Knotenpunkte, erhöht/verringert also das "W" bzw. das "b".

Je mehr Daten, desto genauer wird die Ausrichtung des NN.

Danach lassen wir unser NN auf einen Testdatensatz los, der ihm bis dahin unbekannt ist und schauen ob das NN den weitgehend richtig zuordnet.

Passt alles sind wir auf dem richtigen weg, gibt es eine große Differenz zwischen Trainingsdatensatz und Testdatensatz liegt wahrscheinlich "overfitting" vor, dasss NN hat sich zu sehr auf den Trainingsdatensatz eingeschossen und fährt mit Scheuklappen durch die Gegend. Dannn müssen wir herumoptimieren und das Spielchen wiederholen.

Auf dieser Technologie basiert also der ganze Big Data Krams, und jederman kann mit Anleitung in Phyton oder R ein NN trainieren, das recht zuverlässig Katzenbilder erkennt. Oder er packt ein Framework wie Tensorflow drauf und macht sich die Arbeit noch einfacher. Alles kann das NN allerdings nicht - Gesichtserkennung braucht ne Menge Rechenpower und feinste Technologie, google hat das ne Menge auf dem Kasten und rückt es nicht raus. Jeder der was brauchbares produziert bleibt wohl auf seinem Wissen sitzen.

Natürlich lassen sich auch verschiedene NN zusammenschalten etc pp. Vieles ist allerdings Inginieursmathematik, es hat also wenig mit System und viel mehr etwas mit herumprobieren zu tun. Viele Methoden werden also einfach benutzt, ohne dass der Programmierer versteht was er da macht. Jedenfalls überblickt der Demiurg sein Werk nur teilweise.